東工大ニュース

東工大ニュース

公開日:2021.01.20

東京工業大学 科学技術創成研究院の吉村奈津江准教授(科学技術振興機構さきがけ研究員兼務)、明石航大学院生(研究当時)、神原裕行助教、緒方洋輔特任助教(研究当時)、小池康晴教授、ルドビコ・ミナチ特定准教授は、頭皮で記録された脳波信号(EEG)[用語1]から音声を直接再構築するために有望な手法を開発した。

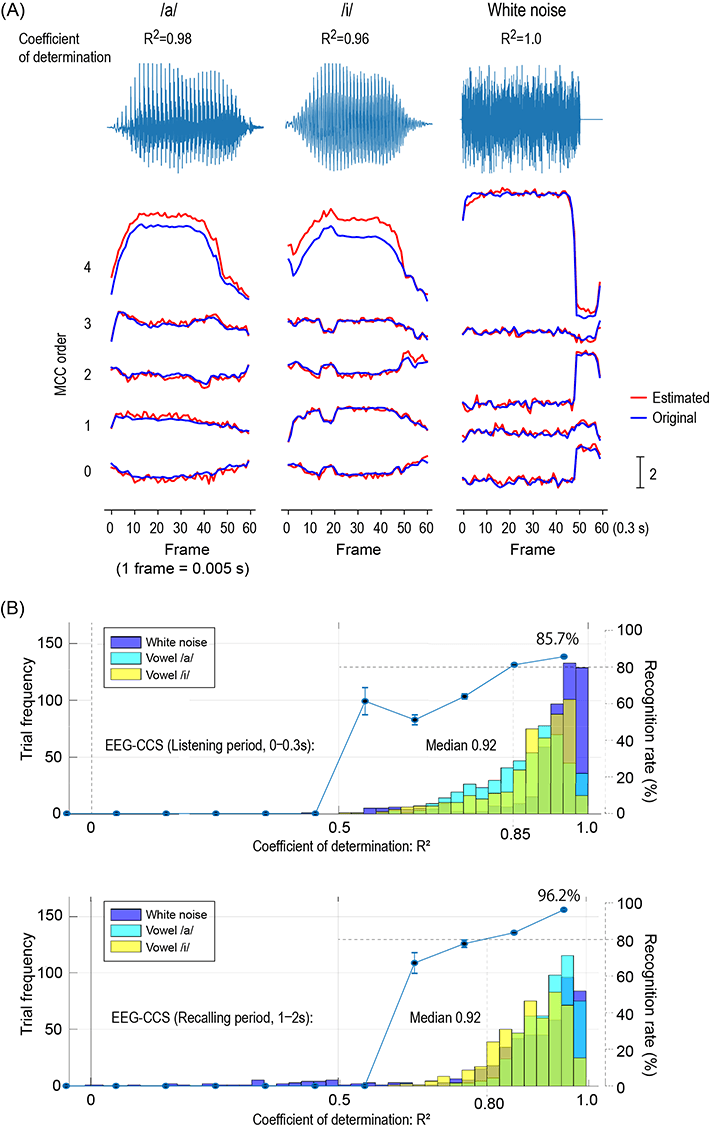

参加者が2つの母音「ア」と「イ」を視聴後に思い出したときに記録されたEEGを用いて、聞かせた音源のパラメータを畳み込みニューラルネットワーク(CNN)[用語2]によって推定した。推定されたパラメータを用いて復元した母音の音声は非常に明瞭で、実際に視聴した者とは別の参加者が音声の弁別を行ったところ、85%を超える認識率を示す音声だった。さらに、音源パラメータの推定のためにCNNが抽出した脳波の特徴は、何の音かを特定するために使われる脳内の聴覚経路(Whatストリーム[用語3])に含まれる領域であり、この手法の脳科学的妥当性も示された。

この抽出された特徴を調べることで、音声を聞いている時とそれを想起している時の脳活動領域の違いがさらに示唆された。この手法はその人がどのように聞こえているか、聞こえていないのか、を客観的に把握し、さらに脳のどこを使っているのかを調べられる可能性があるため、EEGを利用した脳内の聴覚・音声・言語処理の評価が可能になる効果が期待される。

本研究は、ドイツ科学技術誌「Advanced Intelligent Systems(アドバンスド・インテリジェント・システムズ)」に1月7日(現地、ドイツ時間)に掲載された。

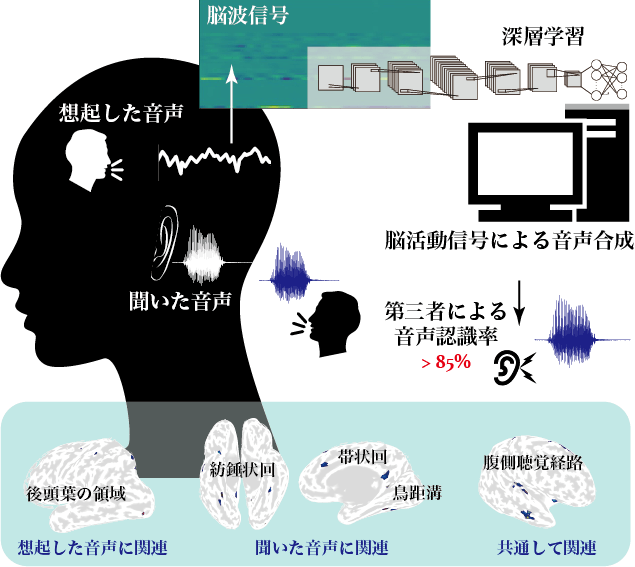

図1. 研究の概念

32ヵ所の脳波信号(EEG)電極から、母音の「ア」、「イ」、および白色雑音を聞いているときと、その後、聞いた音声を想起しているときのEEGを記録し、聞かせた音源のパラメータ信号をEEGから畳み込みニューラルネットワーク(CNN)を用いて推定して音源を復元した。復元された音声が耳で聞き分けられるかどうか聞き取り判別試験を行ったところ、全ての参加者の脳波データにおいておおよそ8割程度の判別が可能だった。

このような高い精度でCNNが音声情報を抽出できたということは、CNNが音源推定に利用した脳の領域と信号の時間的なタイミングは、脳内の音声処理過程を間接的に反映していると考えられる。その領域を調べた結果、脳内の聴覚処理において、何の音かを検知するための信号が処理される「Whatストリーム」と呼ばれる脳領域群が主に使われていることがわかった。

これはコンピュータが抽出した脳内の特徴が脳科学的にも妥当であったことを示唆している。さらに興味深いことに、音を聞いている時と音を思い出した時でCNNが抽出した脳領域に違いがあり、個人ごとの脳領域の違いもみられた。2種類の母音の違いだけを調べた研究だが、この技術をさらに進歩させることで、個人の脳内の聴覚・音声・言語処理のさらなる理解に貢献できるものと期待される。

図2. EEGから推定した音源パラメータ波形と復元した音声の聞き取り精度を示した結果

コンピュータ処理技術の飛躍的な革新に伴い、脳活動信号から脳内の情報を読み出すブレイン・コンピュータ・インタフェース[用語4]に関する研究が近年、盛んに進められている。この技術を用いて、脳内の情報処理過程を知るために研究者が何十年にもわたって注目してきた課題が次第に明らかになってきた。

音声情報の読み出しに関しては、電極を頭蓋骨下の脳皮質表面に埋め込む手術を伴う皮質脳波信号(ECoG)[用語5]を使用して聴覚処理に関連する脳領域から直接信号を取得し、それによって音声合成が試みられている。しかし深層学習[用語6]など、機械学習の最近の進歩にもかかわらず、ECoGを使用しても、聞き取りやすい音声の合成は依然として困難な状況である。

吉村准教授らの研究では、EEGから脳内の神経活動を機械学習により推定し、筋活動、指の動きなど、これまでEEGからでは困難だと考えられてきた情報を抽出することに成功してきた。今回の研究では、音声認識や音声合成に用いられているメルケプストラム[用語7]という音声情報を表現しているパラメータをCNNモデルで推定し、物理的に提示または想起された母音をEEGから合成することができた。

耳で聞き分けられる聴取性能の高い音声をEEGから再構成できたため、本人がどのように聞こえているかを第三者に伝えることができる可能性があり、聴覚検査の客観的な手法として使える可能性がある。また、脳のどの領域が聴覚・音声・言語処理に関係しているのかについての理解を深め、ブレイン・コンピュータ・インターフェイスなどのさまざまな将来のアプリケーションへの道を開く可能性がある。

本研究は、科学技術振興機構(JST)戦略的創造研究推進事業さきがけ「人とインタラクションの未来」(研究総括:暦本純一 東京大学大学院情報学環教授/株式会社ソニーコンピュータサイエンス研究所副所長)研究領域における「脳波を用いたセルフケアサポートシステム」(研究者:吉村奈津江)(JPMJPR17JA)、日本学術振興会科学研究費助成事業(基盤研究(C)15K01849)の支援を受けて実施された。

用語説明

[用語1] 脳波信号(EEG) : 脳内の神経細胞の活動を反映した電気信号を頭皮に付着した電極から記録した信号。

[用語2] 畳み込みニューラルネットワーク(CNN) : 広義の人工知能、機械学習法のひとつで、脳内の神経細胞がネットワークを形成して情報伝達を行う事象を模して数式的なモデルとして表現し、入力された情報の中から目的とする出力を構成するために必要な情報を抽出するために利用できる。

[用語3] Whatストリーム : 脳内の聴覚経路のひとつであり、何の音であるかを特定するための役割があるとされている。耳付近の側頭部から前頭部にかけて位置する領域が含まれると考えられている。音の場所を特定する経路はWhereストリームと呼ばれる。

[用語4] ブレイン・コンピュータ・インタフェース : 脳から記録した信号をコンピュータ処理し、コンピュータやロボットを操作するための指令信号として出力することで、頭で考えるだけでコンピュータやロボットを操作可能にする技術。

[用語5] 皮質脳波信号(ECoG) : 頭蓋骨の下にある脳皮質の表面に外科的手術により設置した電極(シート)から、脳内の神経細胞の活動を反映した電気信号を記録した信号。

[用語6] 深層学習 : CNNのネットワーク構造は層を形成しており、これまでは3層が一般的であったが、近年のコンピュータ処理速度の大幅な向上により、より多くの層(深層)の構造を用いた計算処理が可能となった。

[用語7] メルケプストラム : 特に音声認識でよく用いられる技術で、音源の内容を表す特徴を時系列信号として抽出したもの。

論文情報

掲載誌 : |

Advanced Intelligent Systems |

論文タイトル : |

Vowel Sound Synthesis from Electroencephalography during Listening and Recalling |

著者 : |

Wataru Akashi, Hiroyuki Kambara, Yousuke Ogata, Yasuharu Koike, Ludovico Minati, Natsue Yoshimura* |

DOI : |

お問い合わせ先

東京工業大学 科学技術創成研究院

准教授 吉村奈津江

E-mail : yoshimura.n.ac@m.titech.ac.jp

Tel : 045-924-5066/5086 / Fax : 045-924-5066

取材申し込み先

東京工業大学 総務部 広報課

E-mail : media@jim.titech.ac.jp

Tel : 03-5734-2975 / Fax : 03-5734-3661

科学技術振興機構 広報課

E-mail : jstkoho@jst.go.jp

Tel : 03-5214-8404 / Fax : 03-5214-8432

JST事業に関すること

科学技術振興機構 戦略研究推進部 ICTグループ

舘澤博子

E-mail : presto@jst.go.jp

Tel : 03-3512-3526 / Fax : 03-3222-2066