東工大ニュース

東工大ニュース

公開日:2022.12.02

東京工業大学 工学院 電気電子系の西山伸彦教授、高橋直樹大学院生と、科学技術創成研究院 未来産業技術研究所の雨宮智宏助教らの研究チームは、シリコン基板上低消費電力半導体薄膜レーザ[用語1]を作製し、駆動方法を工夫することで、人工知能における機械学習のためのニューラルネットワーク[用語2](以下、NN)回路に広く利用される活性化関数であるReLU(Rectified Linear Unit:正規化線形ユニット)[用語3]関数を光入出力で実現できることを実証した。

光NN回路は、従来の回路に比べて高速で信号処理ができる可能性があることから注目されている。しかしこれまでは、大規模光集積回路が実現可能なシリコン基板上では、光NN回路の一部である線形処理[用語4]のみが使われており、活性化関数処理は電気信号に戻して行う必要があった。今回の研究により、線形処理部と同一の回路上に、活性化関数処理部を全て光で実現できる可能性が示され、ワンチップ全光NN回路の実用化への道を開いた。この成果はより高度で高速な人工知能の実現につながると期待される。

本研究成果は、10月28日付の「Optics Letter」にオンライン掲載された。

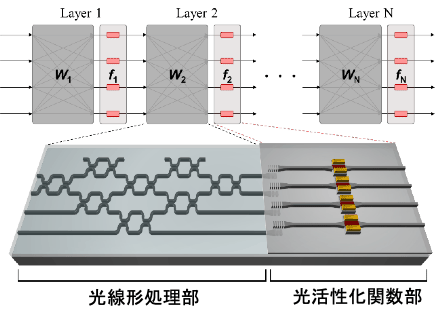

人工知能は近年、日常生活のあらゆるところで活用され始めており、それにともなってより低消費電力でより高速に稼働できるようにすることが求められている。そのためには、コア技術である機械学習・ニューラルネットワーク(以下、NN)回路の進歩が必要になる。光NN回路は光の速度で演算できることから、上述の人工知能の高速化・低消費電力化が期待できる注目の技術である。近年、複数の大学・企業が実用化を進めているが、実現しているのは線形演算を行う一部の機能のみであり、全ての演算処理を光で行う技術の登場が期待されていた。特に、活性化関数と呼ばれる非線形関数は正確な学習のために不可欠な技術であり、その中でも、ReLUと呼ばれる関数は、従来の電子回路上では以前から一般的に用いられている。そこで今回の研究では、このReLU関数を光で実現し、図1のような光線形処理部と光活性化関数部からなる全光NN回路を実証することを目指した。

図1. ワンチップ全光ニューラルネットワーク回路

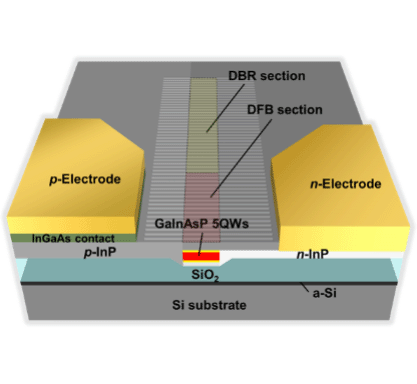

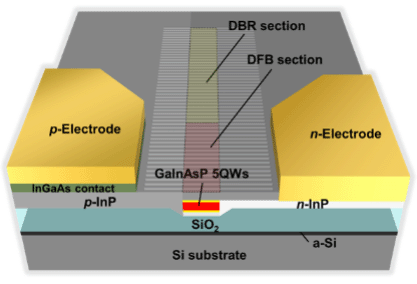

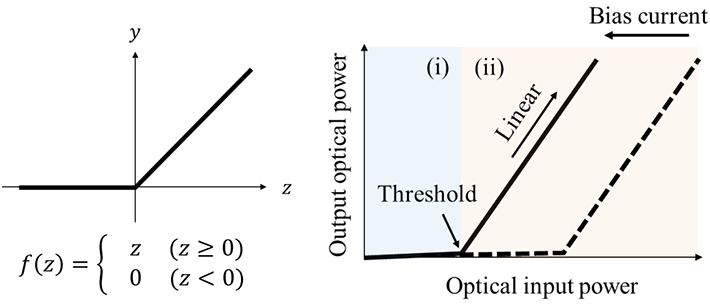

この全光NN回路で用いる光ReLU関数素子の構成としては、西山教授らの研究チームがこれまでの研究において、低消費電力動作が可能であり、かつシリコン基板上に集積可能な半導体レーザとして提案してきた、半導体薄膜レーザを適用した(図2)。これを利用することにより、従来の回路より小さなエネルギーでのレーザ発振動作が可能となる。その駆動方法として、これまでは一般的に、電流を流すことで光を発生させる方法か、別の光を照射することで新たな光を発生させる方法が取られてきた。しかし今回は、レーザ発振をしない範囲で電流を流し、さらに光を照射させることで、ReLU関数(図3左)と同等の入出力特性を光でも実現する(図3右)という、光と電気のハイブリッドの駆動方法を提案した。

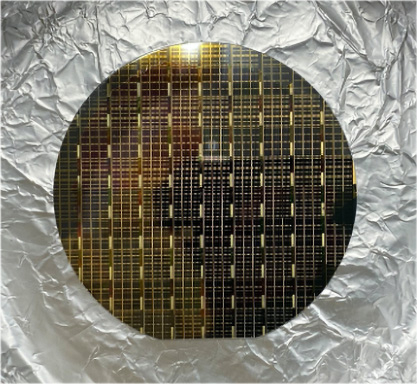

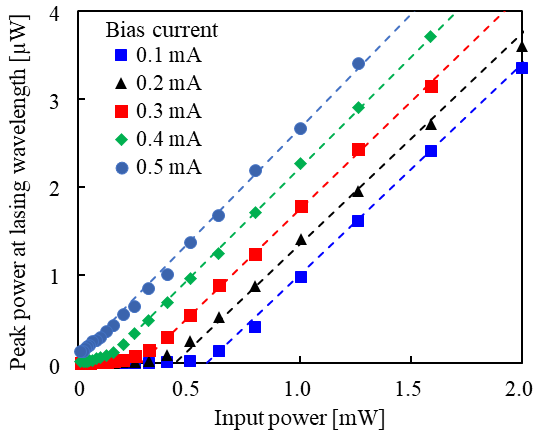

実際に、シリコン基板上に異種材料常温活性化接合という技術によって半導体薄膜レーザを形成し、提案した駆動方法で実験をした結果、ReLU関数と類似の入出力特性を実現できることが明らかになった(図4)。さらに、駆動電流を変化させることで、線形処理部からの光信号の強さによって立ち上がるしきい値が、ユーザー側で自由に変更可能であることも確認した。

図2. シリコン基板上低消費電力半導体薄膜レーザ (左)構造図、(右)ウェハスケール集積素子

図2. シリコン基板上低消費電力半導体薄膜レーザ (上)構造図、(下)ウェハスケール集積素子

図3. ReLU関数(左)理想的な関数、(右)光ReLU関数イメージ

図4. 光ReLU関数の実験結果

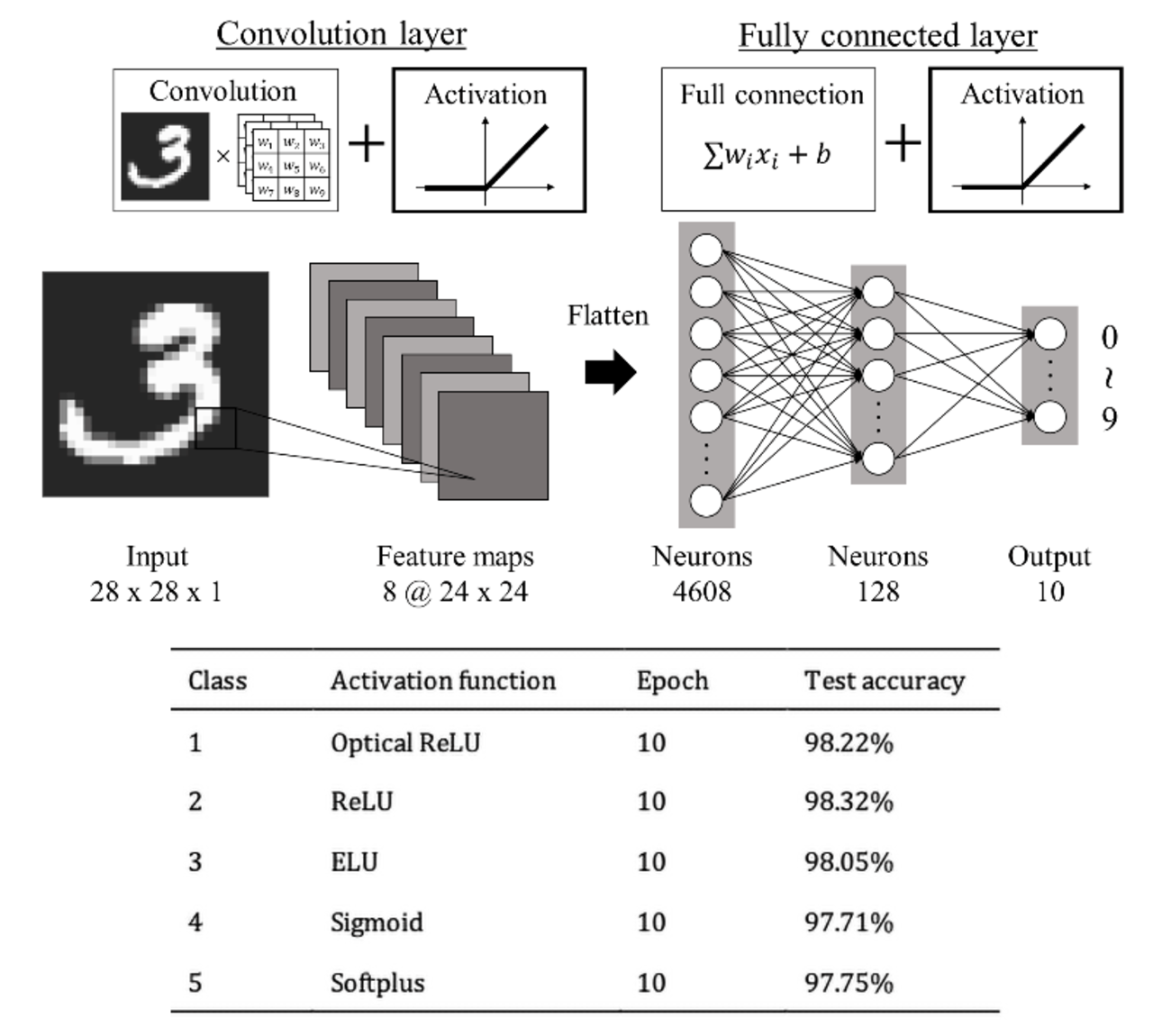

この素子によって実現した光ReLU関数では、数学の観点から理想的な関数形状からはずれが生じる。しかし関数形状を模して、機械学習の学習結果のシミュレーションを行ったところ、理想的な関数形状では精度が98.32%だったのに対し、光ReLU関数の形状でも98.22%という遜色ない値が得られることを確認した(図5)。

図5. (上)光ReLU関数を利用した場合の精度シミュレーション構成、(下)複数の活性化関数を利用した場合の精度比較

今回の研究で実現した光ReLU関数素子は、シリコン基板上に異種材料集積技術によって作製しているため、すでに実用化されている線形処理部を持つ光NN回路と集積親和性が高い。そのため、ワンチップ全光NN回路が近い将来実現できると期待される。全光NN回路は、高速かつ低消費電力で動作することが可能であり、それがワンチップ化することで、末端のサーバや、将来的にはモバイル端末等への導入が実現する可能性がある。そうなれば、より多くの人々が人工知能の発展による利益を享受できるだろう。

本研究をさらに継続し、ワンチップ全光NN回路の実現を目指すとともに、積極的に産学連携を進め、実用化を検討する。

付記

本研究成果は、日本学術振興会科学研究費助成事業(20H02200, 21J14548)、JST-CREST(JPMJCR15N6)によって得られた。

用語説明

[用語1] 低消費電力半導体薄膜レーザ : 発光する量子井戸を有する化合物半導体薄膜(270ナノメートル程度)をガラスや空気で挟むことで、光を化合物半導体へ強く閉じ込めるため、従来より少ない電力でレーザ動作ができるという特長を有する。薄膜のため、異種材料接合によってあらゆる基板の上に形成できる。今回はシリコン基板の上に形成された。

[用語2] ニューラルネットワーク : 元々は生物の神経細胞を模した数理モデルである。具体的には、ある処理単位が相互に接続するネットワークを形成し、それを多層にすることで構築されている。機械学習の手法として用いられる。

[用語3] ReLU(Rectified Linear Unit:正規化線形ユニット) : 活性化関数の一種。ランプ関数とも呼ばれる。活性化関数は、線形処理された信号を次の層に渡す際に、どのように渡すかを規定するために使用され、これにより、より複雑な学習を行うことができる。ReLU関数はその中でも広く利用されている活性化関数で、入力がある値に達するまでは出力が0となり、その値を超えると、入力に対して線形な出力を持つ。

[用語4] 線形処理 : 掛け算と足し算で記載できる信号処理。具体的には、それぞれの入力信号にある重みをかけ合わせた後、その入力信号を足し合わせて次の層への出力とする。

論文情報

掲載誌 : |

Optics Letters |

論文タイトル : |

Optical ReLU using membrane lasers for an all-optical neural network |

著者 : |

Naoki Takahashi, Weicheng Fang, Ruihao Xue, Sho Okada, Yoshitaka Ohiso, Tomohiro Amemiya, and Nobuhiko Nishiyama |

DOI : |

お問い合わせ先

東京工業大学 工学院 電気電子系

教授 西山伸彦

Email nishiyama@ee.e.titech.ac.jp

Tel / Fax 03-5734-3593

取材申し込み先

東京工業大学 総務部 広報課

Email media@jim.titech.ac.jp

Tel 03-5734-2975 / Fax 03-5734-3661